1. 아나콘다 실행

▶️ conda activate begin_env(사용자명) : 아나콘다 활성화

▶️ conda install plotly -y : python 시각화 패키지 설치

⇒ Seaborn 및 ggplot2에서 영감을 얻어 간결하고 일관되며 배우기 쉬운 API를 갖도록 특별히 설계됨

▶️ done → 설치 완료

▶️ jupyter notebook으로 돌아와 방금 설치한 plotly.express를 import함

▶️ names : 각 유형을 나타냄

▶️ title : 파이차트의 제목(좌측 위)

▶️ hole : 가운데 원 크기 조절

▶️ df.head()는 앞에서부터 5가지의 데이터타입을 보여준 반면, df.tail()은 뒤에서부터 5가지의 데이터타입을 보여줌

▶️ df.tail(특정 숫자) : 특정 수 만큼만 데이터타입을 보여줌

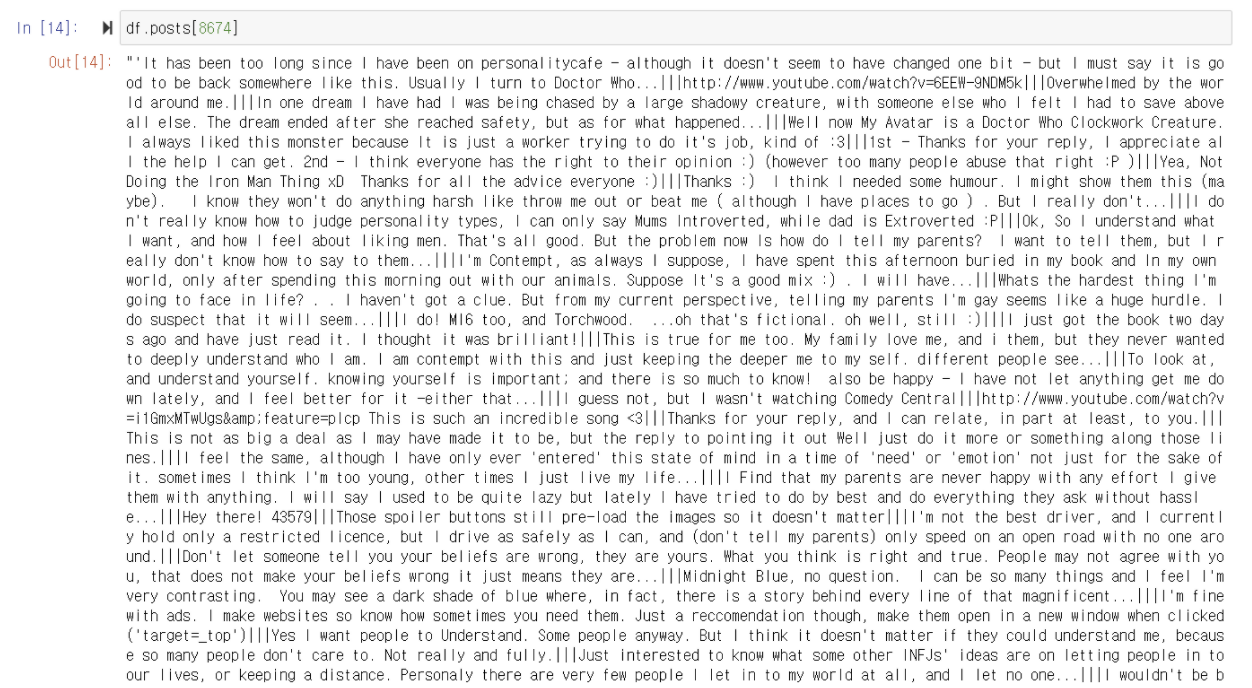

▶️ df.column명[data 순서] : DataFrame의 해당 column에서 해당 순서에 속하는 내용을 모두 보여줌

▶️ 위 내용을 person8674 변수에 저장하고 분석하면 vertical bar(|)를 자주 사용함을 추측할 수 있음

▶️ person8674의 type은 str(문자열)이기 때문에 .split 함수를 사용해 vertical bar를 기준으로 나눌 수 있음

▶️ vertical bar를 기준으로 나누기 전, person8674의 길이는 7418이었지만 나눈 후에는 50개, 즉 50개의 comment가 달렸음을 알 수 있음

다른 MBTI를 가진 사람도 50개 정도의 comment를 남겼을까?

▶️ post colomn에서 다른 MBTI 유형 모두 vertical bar를 기준으로 나누었을 때 대부분 50개의 comment를 남김

▶️ 위 값을 length_comment 변수에 저장하고 px.histogram(변수)를 활용하면 히스토그램을 출력할 수 있음

- comment 당 평균 사용단어 수

▶️ 예를 들어 한 문장을 comment 변수에 저장함

▶️ vertical bar를 기준으로 나눴을 때, comment의 길이는 3임

▶️ 위 3 값을 변수 length_comment에 저장함

▶️ .replace() : vertical bar를 공백으로 바꿔줌

▶️ .split() : 공백을 기준으로 comment를 나눔

▶️ 공백을 기준으로 나눈 comment의 값은 8이고 length_comment의 값은 3이므로 둘을 나누면 2.6666...의 값이 나옴

다른 MBTI를 가진 사람들은 comment에 평균 몇 개의 단어를 사용할까?

▶️ 새로 getWordPerComment 사용자 정의 함수를 만들어줌

▶️ 모든 comment의 vertical bar를 공백으로 대체함

▶️ 공백을 기준으로 comment를 나눠줌

▶️ 위에서 언급한대로 대부분 50개의 comment를 단다고 했으니 50이라고 가정하고 나눠줌

▶️ 0번부터 8674번까지 각각의 평균 단어수가 출력됨

▶️ words_per_comment라는 column을 새로 생성함

▶️ df.head() : 0번부터 4번까지의 type별 comment와 comment별 단어 수를 출력함

▶️ df[['type', 'words_per_comment']] : 전체 DataFrame의 type과 words_per_comment를 출력함

→ 너무 많아 보기 힘들다는 단점이 있음

▶️ .groupby('type') 함수를 통해 type을 기준으로 유형별로 보기 좋게 묶어줌

▶️ .mean() 함수를 통해 가각의 평균을 구해줌

▶️ .sort_values('words_per_comment') : words_per_comment를 기준으로 작은 수부터 오름차순으로 배열해줌

'Data Analysis' 카테고리의 다른 글

| MBTI 테스트 프로그램 (0) | 2021.09.02 |

|---|---|

| Word Cloud 프로그램 (0) | 2021.09.02 |

| MBTI 데이터 분석 프로그램 (0) | 2021.09.02 |

| [ Python ] 데이터 (0) | 2021.09.02 |

| [ Python ] 인덱싱 (0) | 2021.09.02 |